Все о накрутке поведенческих факторов в 2020 году

Содержание:

- Следы аномальной накрутки

- Поведенческие факторы на сайте

- Что использовали для накрутки

- Базовые гипотезы

- Что такое поведенческие факторы

- Почему накрутка поведенческих факторов сегодня неэффективна

- Как проверить сайт на фильтры Яндекса?

- Как накрутить поведенческие факторы

- Как обнаружить факт накрутки поведенческих факторов

Следы аномальной накрутки

Если фильтр наложен объективно, и вы действительно накручивали ПФ, лучше всего сдаться на милость «Яндекса». Но при отсутствии вашей вины нужно попытаться выяснить, что произошло, и уже с обнаруженными следами нарушений обращаться к администраторам поисковика.

Для этого действуйте следующим образом.

- Посмотрите в «Яндекс.Вебмастер» переходы по позициям и поищите среди них аномальные: по тематике «для взрослых» и подобным ключевым запросам, по ключам, которые вы не используете для продвижения, со слишком высокими показателями CTR.

- Посмотрите переходы в «Яндекс.Метрике» и также поищите аномальные.

- Оцените, нет ли неестественных и необоснованных скачков трафика в течение одного дня или времени суток. Если прирост превысил 30 %, и при этом не было никакой объективной причины (сезонность, проведение мероприятия, праздник), выясните, с чем это связано.

Поведенческие факторы на сайте

На просторах сети поведенческими факторами называют ряд возможных действий пользователей, которые они производят на сайтах. Обычно это вход, авторизация, просмотр контента и скачивание файлов, клики на баннеры и ссылки, многое другое. Влияние поведенческих факторов (пф) на ранжирование в поисковых системах неоспоримо, так что их анализ – важнейший этап для оптимизации сайта.

К поведенческие факторы ранжирования сайта yandex и google относятся:

Клики в выдаче поисковой системы. Основное значение придается первому и последнему кликам, ведь, согласно алгоритмам в Яндекс, обычно именно они считаются наиболее релевантными.

Посещаемость ресурса, которая указывает на его популярность и востребованность на просторах сети.

Глубина просмотра, вычисляющаяся из количества просмотренных страниц и бездействие пользователя в ссылочных факторах вашего сайта.

Время нахождения как на сайте в целом, так и в его отдельных разделах в частности. Это важнейший критерий оценки качества ресурса, ведь хороший портал всегда задержит посетителей на длительный срок, когда плохой пользователи покидают практически сразу.

Показатель возвратов – количество вернувшихся пользователей, формирующих постоянную целевую аудиторию.

Показатель отказов, охватывающий пользователей, которые не стали просматривать на сайте более одной страницы

Этот фактор считается отрицательным, указывая на низкое качество сайта и нерелевантность запросу

Важно обратить внимание также на то, что этот критерий не может считаться основным, ведь посетители могли покинуть страницу не только потому, что она не соответствовала их ожиданиям, но и вследствие того, что они сразу нашли ответ на свой вопрос.

Таким образом, влияние на продвижение поведенческими факторами тесно связано со статисткой и посещаемостью сайта, уникальностью его содержимого, удобством использования и общей привлекательностью для пользователя.

Этот алгоритм ориентирован на улучшение качества и конкурентоспособности ресурса, ведь сайты с положительной оценкой поведенческих факторов всегда превосходят аналоги при прочих равных условиях. Поэтому поведенческие факторы ранжирования Яндекс так важны для продвижения.

Изначально появление поведенческих факторов стало попыткой поисковых систем сделать выдачу максимально достоверной, избавляясь от внешнего влияния и махинаций. Чистота поиска – основная цель большинства разработчиков, так что постоянно появляются все новые алгоритмы ранжирования. К тому же, сайты с положительными показателями с точки зрения seo продвижения, будут подниматься в топе выдачи быстрее.

Что использовали для накрутки

Изначально планировали использовать несколько разных сервисов для накрутки, но найти «живые» инструменты оказалось затруднительно. Поэтому остановили выбор на Userator. Использовали стандартный Userator и SEO Bonus. Но основные силы были направлены на ручную накрутку.

Как работает Userator

Заказчик оплачивает каждую сессию (11 рублей за сеанс). Специальное ПО на компьютерах исполнителей присылает им пошаговые инструкции и делает контрольные скриншоты. Исполнители – реальные люди с IP-адресами из разных регионов, зарегистрированные в сервисе.

Единая схема задания в Userator:

1. Вводится запрос-синоним.

2. Выбирается регион поиска: Москва (в Яндексе).

3. Вводится целевой запрос.

4. Осуществляется переход на 2 случайных сайта.

5. Беглый просмотр открытых страниц.

6. Возврат на выдачу.

7. Переход на целевой сайт.

8. Просмотр 2–3 страниц на целевом сайте в течение 1–2 минут.

9. Конец сессии.

Как работает SEO Bonus

В SEO Bonus взаимодействие инструмента и исполнителя происходит через Telegram-бот, соответственно, упор делается на мобильные устройства. Бот присылает одно задание в день, они проще, чем в Userator, но стоят дороже (20 рублей за сеанс). Из-за того, что заданий меньше, пользователь выглядит более реалистично.

Пример задания

Ручная накрутка

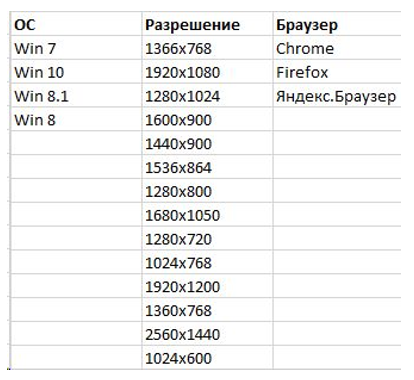

Для ручной накрутки был арендован сервер, на котором поднимали определенное количество виртуальных машин со своими конфигурациями: операционная система, разрешение и проч. На каждой машине было несколько браузеров (Firefox, Chrome и Яндекс.Браузер). В каждом браузере по несколько десятков отдельных пользовательских профилей. Каждому пользователю выделяли отдельные резидентные прокси московского региона. В общей сложности получили 168 вариантов конфигураций с несколькими десятками профилей.

Для проверки гипотезы «Владелец или конкурент» нужно было убедиться, умеет ли Яндекс отличать, кто накручивает ПФ. Для этого сайты разделили на две группы:

- «Владелец»: максимум компрометации связи между аккаунтом в сервисе накрутки и Яндекс.Вебмастером. Установлены расширения от Яндекса (Погода, Почта и т.д.), регулярные посещения сервиса и Вебмастера.

- «Конкурент»: следили, чтобы не было оснований связать сессию с владельцем сайта.

С помощью ручной накрутки также проверяли гипотезу «Пользователь с историей vs пользователя без истории». Соответственно, часть пользователей работала по сценарию максимально приближенному к реальному (сессии с «историей»): это реалистичные аккаунты, с номерами телефонов, Яндекс.Диском, привязкой и сохраняемыми файлами cookie. И были «чистые» сессии, для которых удалялась вся информация о предыдущих поисковых сессиях.

При этом поведение пользователей определялось не единым паттерном, как в Userator, а было максимально разнообразным:

Для накрутки брали запросы, которые находились в ТОП 50 выдачи.

Сколько крутили:

- 20–30% от частотности запроса, если он в ТОП 20/50;

- в случае с низкочастотными запросами (до 5 точных показов) – 1–2 визита в месяц;

- брендовые (все нулевые) – 1–10 визитов в месяц, исходя из позиции;

- крутили, пока запрос устойчиво не попадет в ТОП 5.

Информация о сайтах, участвовавших в эксперименте

Тематика: продажа кошек породы мейн-кун.

Региона: Москва.

Семантика: ~250 ключей.

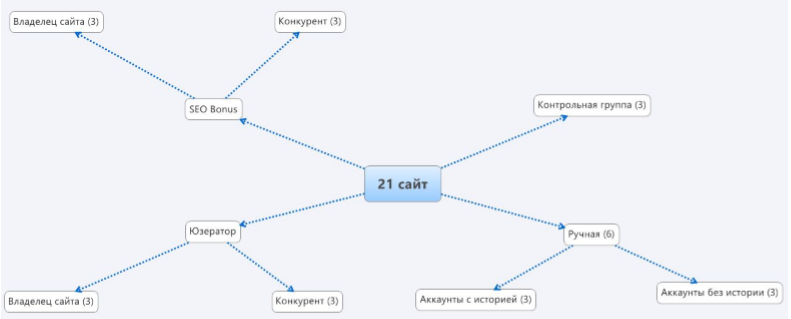

Для проведения экспериментов создали 21 сайт – семь групп по три сайта в каждой:

- Основная группа Userator (6 сайтов) делится на две подгруппы «Владелец сайта» (3 сайта) и «Конкурент» (3 сайта).

- Основная группа SEO Bonus (6 сайтов) делится на две подгруппы «Владелец сайта» (3 сайта) и «Конкурент» (3 сайта).

- Основная группа «Ручная» (6 сайтов) делится на «Аккаунты с историей» (3 сайта) и «Аккаунты без истории» (3 сайта).

- «Контрольная группа» (3 сайта) – их не крутили.

Подробнее про сайты:

- Домены новые, зарегистрированы примерно в одно время, все домены без истории.

- Все сайты на разных IP-адресах (публичные хостинги: sweb, timeweb, beget и тд).

- WordPress, разные паблик-шаблоны.

- Одинаковое количество страниц.

- Яндекс.Метрика, Яндекс.Вебмастер, Google Search Console, GA.

Была проведена базовая внутренняя оптимизация:

- Написаны тексты одинакового объема с равным количество ключей, распределенных в тексте по одному принципу (12–15 тысяч знаков на один сайт).

- Сделан каталог котят: изображения, цены.

- Уникальные title.

Региональность:

- Для Яндекса был присвоен регион «Москва» через Яндекс.Вебмастер.

- Для Google добавлена организация с адресом на Google Maps (везде разные мобильные номера).

Базовые гипотезы

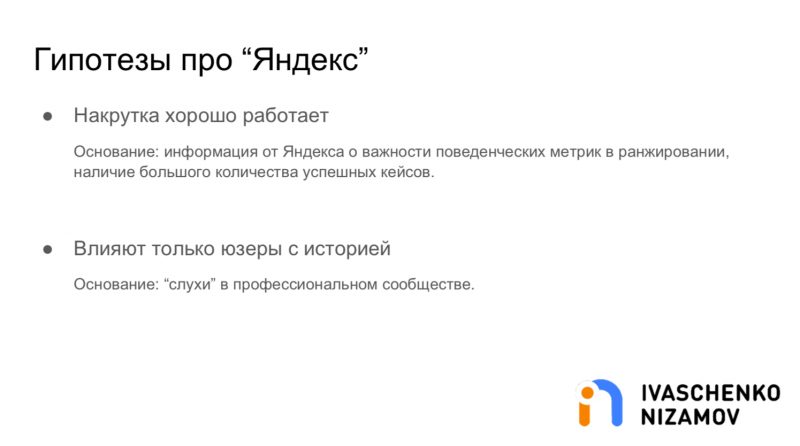

В декабре прошлого года мы планировали этот эксперимент. Выработали базовые гипотезы, которые хотели проверить. Самое фундаментальное касательно Яндекса, у нас 4 гипотеза. Самое главное — как реагируют, хорошо ли реагируют, работает ли.

Второе — это на уровне слухов у нас есть такая гипотеза, что Яндекс отличает, кто занимается накруткой, владелец сайта или конкурент, чтобы случайно не получилось, что забанят сайт, который крутили конкуренты. Попробуем тоже проверить.

Третья гипотеза про то, что Яндекс по-разному подходит к пользователям с историей и без истории. Если пользователь без истории, то он его игнорирует. Еще хотелось бы понять, действительно ли разная степень рисковости инструментов, публичные сервисы, непубличные сервисы, насколько это влияет на опасность этого мероприятия.

Про Гугл гипотез, как и слухов, поменьше. Главное состоит в том, что в гугле поведенческие не тащат, не работают. И сама поисковая система об этом заявляет, и много на эту тему размышлений.

Вытекающее из этого — это то, что, если не работают поведенческие, то и забанить за них не могут тоже.

План рассказа такой: сначала расскажу про технологию, как именно крутили, какие методы использовали, инструменты, потом про сайты, которые были у нас подопытными и общую хронологию, потом резюмирую.

Что такое поведенческие факторы

Поведенческие факторы определяют то, насколько сайт нравится пользователю. Сюда можно включить время, которое читатель проводит на сайте или отдельной статье, уровень его вовлеченности, количество повторных заходов на сайт, прокручивание страницы, клики по определенным элементам и т. д. То есть это понятие объединяет в себе все показатели, которые могут говорить о том, что определенный проект нравится пользователю или, наоборот, не нравится.

Как я и сказал ранее, поведенческие факторы сейчас являются основной метрикой при ранжировании ресурсов в поисковой выдаче. Именно с помощью этого показателя ПС определяют качество сайта. Яндекс для этого ввел отдельный показатель – ИКС (Индекс Качества Сайта), который пришел на смену тИЦ. Он также формируется исходя из нескольких метрик, главная из которых – поведенческие факторы.

Сайты с хорошими ПФ могут взлетать на топовые позиции очень быстро. В Яндексе сайт может сразу занять топ-3 и остаться там. Но при условии, что у этого ресурса будет хороший уровень ПФ. Связано это с работой алгоритмов, которые определенным образом помогают молодым сайтам продвинуться.

Также существует немало споров о том, что поведенческие факторы теперь полностью затмевают SEO. То есть даже если у проекта нет вписанных метатегов, ключей в статьях с нужной частотностью и т. д., то хорошие ПФ все равно смогут вытащить его на первые места.

Отчасти это правда, теперь ключи в статьях играют куда меньшую роль, чем раньше. В абсолют возводится именно информационная ценность статьи. Если материал имеет ключи, но не дает пользователю информацию, то ни о какой ценности говорить не приходится. Такая статья может пробыть на топовых позициях пару дней, а потом она стремительно полетит вниз.

Сейчас можно говорить о том, что ПФ не заменяют SEO, а модернизируют его. То есть поведенческие факторы – это значимая часть поискового продвижения, которая обязательно должна учитываться специалистами. Идеальная статья действительно должна содержать в себе ключевые запросы, но они должны быть уместными. Само присутствие ключа никак не повлияет на продвижение, куда лучше будет, если на основе этого ключевого запроса вы донесете какую-то важную информацию.

Исходя из этого меняется и некоторая суть семантических ядер. Хороший текст действительно будет содержать ключи, но сам факт их наличия уходит на второй план. Куда лучше будет взять ключ и раскрыть его суть – дать пользователю необходимую информацию, за которой он и пришел. Именно в этом и кроется смысл хорошего контента и высоких поведенческих факторов.

Сами посудите, если пользователю будет интересно изучать материалы, то он пробудет какое-то определенное время на странице. Если таких пользователей будет много, то поисковик начнет считать ваш сайт интересным.

ПС выгодно продвигать именно качественные и интересные площадки, потому что они будут формировать основной информационный костяк, который будет разбит по тематикам.

Низкокачественные сайты только захламляют интернет-пространство, пользователи остаются недовольны той информацией, которая есть на подобных помойках. Если таких недовольных будет слишком много, то они просто перестанут пользоваться поисковыми системами. Это нанесет огромный урон как самим поисковикам, так и рекламодателям. В общем, здесь все сложнее, чем кажется.

Теперь, чтобы вам было понятнее, разберем все на тезисы:

- поведенческие факторы – это элемент современного SEO;

- они определяют качество и пользу ресурса для простых посетителей;

- благодаря поведенческим факторам улучшается общее качество сайтов на топовых позициях в поисковой выдаче;

- сайты с плохими поведенческими будут на дне выдачи. ПС будут накладывать фильтры, пессимизировать, исключать.

Почему накрутка поведенческих факторов сегодня неэффективна

Накрутка поведенческих факторов представляет собой повышение значения различных показателей действий людей на сайте искусственным путем. Это осуществляют специальные программы или сами пользователи, которые намеренно переходят на конкретные веб-ресурсы из поисковой выдачи, работая в программах по определенным задачам. Такие заказные посетители имитируют поведение настоящих пользователей: смотрят не одну, а несколько страниц, находятся на каждой из них определенное время и т. д. Иногда для улучшения конверсии они могут сделать заказ.

Подобные манипуляции на веб-ресурсе сигнализируют поисковым системам о его привлекательности и удобстве для клиентов, поэтому они повышают ранжирование. Однако этот факт из области теории.

Что касается практики, то за накрутку поведенческих факторов применяются санкции. «Яндекс» ввел их в середине 2011 года, пессимизировав, то есть понизив в выдаче, приличное число веб-ресурсов.

При этом данные тактики никуда не делись и продолжали применяться до 2014 года. Тогда произошло очередное массовое попадание сайтов с нечестной накруткой под фильтр «Яндекса», то есть в бан, с потерей трафика, а значит, прибыли. В настоящее время работа фильтра проходит в автоматическом режиме. Результаты его работы проверяются в метрике.

Фильтр за накрутку сайта влияет на место в выдаче по витальным или, как они еще называются, брендовым запросам. Брендовые запросы делаются строго по названию фирмы, марки продукта или бренда без всяких дополнительных фраз.

Специалисты по сайтам, искусственно завышающие поведенческие факторы, продолжают предлагать свои услуги. Для этого они используют сервисы по быстрому продвижению, которые обещают, что от веб-мастеров потребуется минимум усилий для раскрутки, поскольку большую часть работы они берут на себя. Функция сервисов заключается в создании сложных алгоритмов для накрутки поведения пользователей. Они включают в себя переходы с выдачи на веб-ресурс, переход по ряду ссылок, чтение материалов в течение заданного времени, скролл указанных страниц с конкретной скоростью и прочее.

Есть программы, которые воспроизводят поведение человека за компьютером. Специалисты по SEO активно их используют. Например, это может быть ZennoPoster.

Программы заходят с разных устройств, браузеров и адресов IP. Они программируют алгоритмы и в требуемой последовательности воспроизводят посещения веб-ресурса.

Так называемых псевдопосетителей сайта немного. Они составляют маленький процент от реального трафика по запросу. Если их будет большое количество, то для поисковиков станет заметно, что поведенческие факторы пытаются накрутить. Но если алгоритм достаточно сложный, то вычислить его будет непросто.

SEO-специалисты обычно не афишируют такой способ продвижения веб-ресурса. Да и пользуются накруткой поведенческих факторов из них лишь единицы.

Может получиться так, что сайт не забанили, несмотря на то, что для его продвижения несколько месяцев используется накрутка поведенческих факторов

Но в дальнейшем у него вряд ли получится сохранить свои позиции в выдаче, потому что рано или поздно алгоритмы поисковика накрутку все равно заметят, обратив внимание на завышенные результаты в отдельных периодах.. В этом случае веб-ресурс может лишиться своей позиции в поисковой выдаче, и это будет еще вполне благоприятный исход

Хуже, когда его исключают из поиска.

В этом случае веб-ресурс может лишиться своей позиции в поисковой выдаче, и это будет еще вполне благоприятный исход. Хуже, когда его исключают из поиска.

Алгоритмы поиска разработали автоматическую систему вычисления действий с выдачей. Существует ряд признаков, по которым она распознается:

Слишком высокая активность на сайте, особенно когда ресурс молодой или ранее ничем подобным не привлекал внимание.

Неестественно выглядят заходы на сайт, особенно явно выделяются пользователи, пришедшие по коммерческим запросам.

Один источник накрутки кликов. Это может быть единственное IP или постоянное посещение какого-то веб-ресурса, например биржи с платными кликами

Именно так определяют пользователей-кликеров, которые повышают сайту конверсию, а потом опять приходят на биржу.

Естественные колебания не учитываются. Заходы на сайт по определенным запросам вполне прогнозируемы. Они происходят в конкретные часы, время суток, дни. Автоматическими сервисами такие прогнозы не учитываются, и если SEO-оптимизатор прибег к их услугам, то сайту грозит попадание под фильтр.

Подобные сервисы в основном пользуются одним сервером. Поисковики обычно вычисляют сервер, на который возвращаются с сайта коммерческие пользователи.

Как проверить сайт на фильтры Яндекса?

Итак, давайте теперь расскажу, как определить находится ли Ваш сайт под фильтром Яндекса или же это просто плохое отношение пользователей и Ваш сайт сам по себе не интересный для них.

Способ №1. Во-первых, если Вы заметили, что что-то творится с вашим проектом или он плохо ранжируется в выдаче, то незамедлительно напишите в поддержку Яндекса, связаться с которой можно через панель вебмастера в разделе обратная связь. Система интерактивной помощи сама даст рекомендации по той или иной причине, но если ответ не будет найдёт, то появится возможность заполнить форму и отправить Платону. Но будьте готовы к тому что ждать придется от 4-10 дней, вся зависит от загруженности, хотя на некоторые запросы мне отвечали уже в течении суток. Проанализировав проекты, в которых вебмастера использовали накрутку поведенческих факторов Платон (поддержка Яндекса в лице Платона Щукина) ответил как всегда шаблонным сообщением:

Подождав недельку, я снова решил отправить более подробный запрос с разъяснением и попробовать надавить на жалость поддержки и вытянуть у них как можно более подробную информацию о причинах наложения санкций на что получил очередной стандартный ответ где, они сообщаю, что от них ничего не зависит и все наладиться само собой, нужно лишь отказаться от незаконных способах продвижения и «ждать у моря погоду».

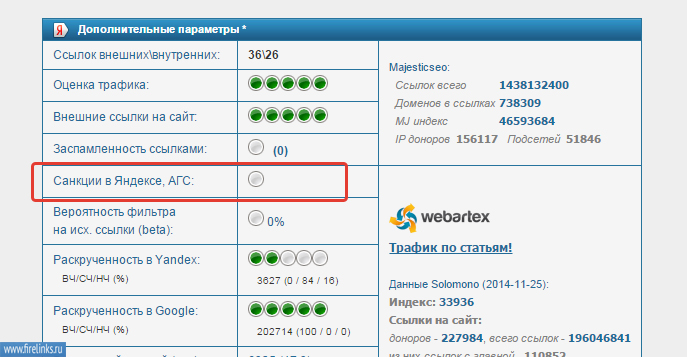

Способ №2. Прогоните сайт через сервис XTOOLS.RU и посмотрите результат в разделе наложенные фильтры.

Способ №3. Установить бесплатное расширение Rdsбар для браузера. При открытом сайте переходим в плагин и в левой верхней части окна программы в разделе ТИЦ если появилась надпись АГС, то считайте, что Вы в глубокой жо…

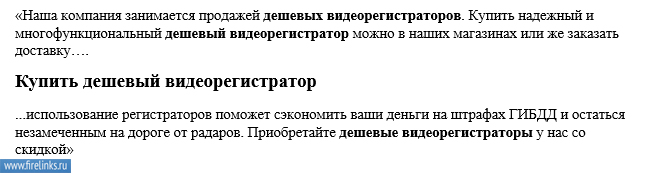

В общем сами виноваты и причину проблем искать необходимо только в самих способах применяемой раскрутки и качества контента. А многие причины наложения фильтров как раз и находятся в самом контенте. Если посмотреть на типичные ошибки при написании статей, то сразу видно, что для того чтобы раскрутить свои сайты многие начинают раскидывать по всей статье в огромном количестве нужный запрос, так сказать затачивать под него материал, и тем самым не замечают, как «заспамливают» всю статью и сайт в целом. Приведу пример переспамленного абзаца сайта по продаже видеорегистраторов:

Как видите в статье используется частое употребление определенного ключевого запроса как в абзацах, так и в самих заголовках и подзаголовках. Если читать переспамленный текст, то сразу будет виден акцент определенное словосочетание, которое может быть неуместно использовано или же употреблено чуть ли не через предложение. Как правильно писать оптимизированные статьи я писал тут, обязательно почитайте.

Вот основной перечень тех негативных факторов, которые могут служить поводов для наложения фильтра от Яндекса:

- Переспам ключевых запросов в материалах сайта;

- Продолжительная недоступность сайта;

- Увеличенный показатель отказов пользователей на сайте;

- Большое количество рекламы на сайте и в самих материалах;

- Медленная загрузка ресурса;

- Неграмотное использование сервисов накрутки поведенческих показателей;

- Покупка большого количества SEO ссылок для продвижения запросов;

- Наличие обратных ссылок с сайтов-помоек, созданных для продажи ссылок и распространения спама;

- Плохая история купленного домена;

- Резкое снятие купленных обратных ссылок с таких бирж как Sape, Webeffector и Rookee;

- Неестественное поведение на сайте пользователей;

- Частое употребление точных вхождений запросов в бэклинках.

Как вы уже поняли из выше сказанного попасться можно на многих мелочах, которые на первый взгляд не видны. Поэтому при продвижении советую использовать только надежные и проверенные методы продвижения, они еще называются “белое продвижение”. Не стоит экспериментировать и рисковать с накруткой, делайте свой блог или же сайт компании как можно более полезным, привлекательным для пользователей и показатели сами увеличатся.

Страхуемся от недоброжелателей

Также существую и независящие от Вас действия, которые могут повлиять на ранжирование Вашего сайта в выдачи и это накрутка показателей недоброжелателями. К примеру у Вас успешный сайт и находится в ТОПе выдачи и там же находится сайт Вашего конкурента, которому Вы мешаете и всячески неугодны. И что он делает в таком случае, ничего умного, он создает компанию и начинает накручивать Вам поведенческие показатели. Уберечься от этого очень трудно. В обязательном порядке проверяйте трафик в разделе Яндекс.Метрика и Гугл аналитика, и в случае обнаружения резкого показателя отказов или же постороннего, нецелевого трафика сразу же пишите в поддержку. На запрос с такой проблемой Платон ответил следующим сообщением:

Как накрутить поведенческие факторы

Есть три способа: делать это самостоятельно, заказывать на буксах или использовать специальные сервисы или программы. Давайте рассмотрим каждый из них подробнее.

Самостоятельная накрутка поведенческих факторов отнимает много времени и подходит, только если нужно продвинуть сайт по каким-то низкочастотным запросам в нише, где нет конкурентов-гигантов.

Для самостоятельной накрутки вам понадобится имитировать действия с множества разных устройств, браузеров и в некоторых случаях регионов. Если выполнять все действия с одного и того же компьютера, просто с разных аккаунтов, система поймет попытку обмана. Для имитации можно использовать специальный софт — например, мы уже рассказывали в отдельной статье о браузере «Мультилогин». Он позволяет создать видимость множества разных устройств с одного.

Накрутка поведенческих факторов на буксах выглядит так: вы создаете задание, человек его выполняет, вы платите. Например, можно попросить пользователей ввести определенный запрос, найти ваш сайт, кликнуть по нему, пробыть на странице 1,5 минуты и закрыть результаты выдачи.

Также на буксах есть серфинг — это когда пользователи автоматически заходят на ваш сайт по прямой ссылке и проводят там не менее 40–50 секунд, а система начисляет им вознаграждение. Такой метод накрутки менее эффективный, потому что поисковые роботы видят, откуда идет трафик, и замечают, что люди неактивны на странице — в большинстве случаев они открывают ее и просто ждут окончания таймера, но не читают текст и не смотрят товары.

Сервисы, приложения, программы и боты для накрутки поведенческих факторов работают по схожим принципам: запускают ботов, которые выполняют определенные действия по заданным алгоритмам. Они, как и реальные пользователи, могут найти ваш сайт в поисковой выдаче, зайти на него, полистать страницу, перейти на другую и так далее. И так — десятки и сотни раз в минуту.

Но алгоритмы поисковых систем и сервисы аналитики научились определять, кто совершает действия — человек или боты. И прекрасно видят, когда вебмастер пытается накрутить так поведенческие факторы, особенно если при этом не идет органический трафик.

Это — отчет по роботам в Яндекс.Метрике. Сервис аналитики понимает, что на сайт заходят не живые люди, а боты

Есть масса сервисов, работающих с накрутками. Вот некоторые из них:

- Userator. Предлагает продвижение в топ разными способами, в том числе формированием поисковых подсказок в Яндексе и Google. Можно заказать автоматическое и ручное выполнение накрутки. Ручное стоит 80 ₽ за одно задание и включает в себя накрутку и внутренних, и внешних факторов.

- MegaIndexPF. В нем можно заказать автоматическое продвижение. Стоимость зависит от конкуренции, текущей позиции в выдаче и других параметров.

- SERP Click. В сервисе все задания выполняют живые люди. Цена за один переход начинается от 5 ₽.

Есть и другие подобные площадки — на одних задания выполняют живые люди, на других всю работу делают боты. Лучше выбирать «живое» выполнение, потому что так поисковые системы не отнесут визиты к посещению роботов и будут учитывать их при дальнейшем ранжировании сайта.

Как обнаружить факт накрутки поведенческих факторов

Известны десять главных признаков, которые указывают на накрутку поведенческих факторов:

IP-адреса пользователей-кликеров не меняются. Чтобы их определить, необходимо в системах оптимизации факторов поведения сделать пробный проект с маркерными запросами, то есть популярными, которые наиболее точно характеризуют как сам веб-ресурс, так и продукт. Далее выделенные запросы отслеживают в поисковой выдаче. То есть за определенное количество дней или недель вы отмечаете все подозрительные IP, которые замешаны в искусственной накрутке, а потом либо анализируете их, либо учите свои собственные алгоритмы их находить. По IP-адресу собираются все запросы, по которым идет накрутка поведенческих факторов.

Витальные запросы с подозрительных IP-адресов. Такие запросы еще называются навигационными, и накручиваются они для улучшения брендовой части поиска. По ним поисковики распознают, кто именно занимается подобными нечестными манипуляциями.

Эксплуатация сервисов «Яндекса» с отмеченных IP-адресов. Часть систем накрутки, отмеченных поисковиками, привязывают сервис Яндекс.Метрики и входят в нее через свои IP. Таким способом вероятность бана сайта через накрутку поведенческих факторов уменьшается, поскольку сервисы доступны только хозяину веб-ресурса.

Применение пользователями-кликерами Яндекс.Браузера или Яндекс.Бара. Через них можно отследить использование сервисов накрутки поведенческих факторов и пометить кликеров.

Наблюдение за реферером. Бывает, что системы перенаправляют посетителей на поисковые результаты по продвигаемым запросам с целью вернуть их на сайт, который накручивает поведенческие факторы. Когда человек перенаправляется, сохраняется информация, откуда он пришел, то есть реферер

По данному рефереру становится понятно, нужно ли принимать во внимание поведение такого посетителя в алгоритмах.

Нет достижения целей. Может возникнуть ситуация, когда на веб-ресурсе после накрутки поведенческого фактора повысился целевой трафик

При этом достижение целей в Яндекс.Метрике выставлено прежнее. Для поисковиков это сигнал непонятной ситуации с трафиком.

Увеличение трафика без изменений на сайте. Поисковики понимают, что органический трафик повышается, если меняется алгоритм или один из конкурентов, который был выше в топовой выдаче, спустился вниз. Но ничего из этого не случилось, изменений на сайте нет, а органический трафик увеличился, причем по несезонным запросам. Это повод к подозрению в накрутке поведенческих факторов. Поисковики проводят анализ, и, если накрутка подтверждается, сайт попадает под фильтр.

Действия пользователей происходят по шаблону. Для идентификации шаблонных действий в кликстриме, то есть последовательности посещений пользователем веб-ресурсов, есть разные методики. Раньше они применялись в контекстной рекламе в качестве защиты от кликфрода (от англ. clickfraud — мошенническое нажатие), а сейчас могут использоваться для анализа органической выдачи.

Неравномерное распределение между устройствами или браузерами. Большая разница видна, когда по посещениям разделяют обычных людей и тех, кому предложено установить программное обеспечение, или ботов. Если последних гораздо больше, то этот факт тоже является поводом к подозрению в накрутке.

Средняя длина сессии в совокупности с остальными шаблонными признаками. В данном случае система обучается выявлению шаблонов в поведении пользователей на небольшой отмеченной выборке. Но ошибки в том, кто заказчик накрутки поведенческих факторов, быть не должно, чтобы не захватить ни в чем не повинные веб-ресурсы.

При корректно сформулированной задаче определить накрутку поведенческих факторов вполне реально. Надо четко понимать, что за три года поисковые системы сильно продвинулись в этом направлении, поэтому имеет смысл поискать другие, честные методы продвижения. Например, Платон Щукин, вымышленный персонаж из технической поддержки «Яндекса», уже давно рекомендовал развивать сайт для пользователя.